本文介绍了模式识别的贝叶斯决策,包括贝叶斯公式、最小错误贝叶斯决策、最小风险贝叶斯决策。

1. 决策理论与方法

如果每一类在空间中互不相交,有清晰的决策边界,这种叫做确定统计分类。如果这些类相互之间有重合,新的样本的特征落到一个重合区域,那么就要判断该样本属于某一类的概率。从而通过比较某些概率的大小来进行分类,这种叫做不确定统计分类。

确定统计分类也可以通过设计线性分类器来完成分类,而对于不确定统计分类,一方面可以继续采用线性分类的思想设计分类器,另一方面也可以采用本文将要介绍的贝叶斯决策。后面我们会看到,线性分类的最优分类器是最小错误贝叶斯决策。

1.1. 基于先验概率的决策

记 $x$ 为观察到的样本特征,分类空间为 $A={a_1, a_2, \cdots, a_n}$,其中 $a_i$ 为第 $i$ 类,$p(A)$ 为该空间的发生概率(先验概率分布)。

- $x=[x_1, x_2, \cdots, x_d]^\top$ 为由 $d$ 维空间组成的特征向量。

- 当 $p(a_j)>p(a_{others})$ 时,记决策规则 $x\in a_j$。

- 当作出决策之后,单分类错误率 $p(error_j) = 1-p(a_j)$,即 $x\notin a_j$ 的概率。

现假设你面前有10张卷子,老师告诉你有 5 份是说没有复习实际也没有复习的学渣的,有 5 份是说没有复习却复习的很好的学霸的,你从里面任意抽了一份出来,不看分数不看名字,问你卷子是学渣还是学霸的。此时由于你只知道学渣学霸的试卷各占一半,因此你只能随便猜一个答案,那么你的单分类错误率是 $0.5$。此时就是基于先验概率的决策。

可以看到,一般决策过程仅依靠先验概率 $p(a_j)$,使得对 $x$ 的观察(特征,也就是试卷分数)并没有对决策过程产生影响,总体错误率仍有降低的空间。

1.2. 基于贝叶斯公式(后验概率)的决策

贝叶斯决策(Bayes Decision) 是十大经典机器学习算法之一,是统计机器学习的典型。通过观察到样本的特征 $x$ 后,通过贝叶斯公式,可以有效降低错误率。贝叶斯决策也被称作统计决策理论。

现假设你面前有10张卷子,老师告诉你有 5 份是说没有复习实际也没有复习的学渣的,有 5 份是说没有复习却复习的很好的学霸的,你从里面任意抽了一份出来,得分90+,不看名字,你多半会说这是学霸的卷子,或许你没有发现,在你做判断的一瞬间已经无意中使用了贝叶斯决策。

贝叶斯公式旨在通过一个已知的结果,并结合一些经验性或统计性的信息来倒推出最可能产生该结果的原因,即所谓执果索因。对于一个 $c$ 分类任务,贝叶斯公式如下

\[p(\omega_{i}\mid x)=\frac{p(x\mid\omega_{i})p(\omega_{i})}{p(x)}=\frac{p(x\mid\omega_{i})p(\omega_{i})}{\sum_{j=1}^{c}p(x\mid\omega_{j})p(\omega_{j})},i=1,2, \cdots c \tag{1}\]其中,举例说明($c=2$)如下:

- $\omega_1,\omega_2$:表示两个类别,此处分别为学渣、学霸;

- $p(\omega_{i})$:表示类别 $i$ 的先验概率,即每一类样本整体出现的概率,此处 $p(\omega_{1})=0.5=p(\omega_{2})$,表示两类试卷各占一半;

- $x$:表示观测/抽样数据,假设 $x=1$ 为拿到90+分的试卷,$x=0$ 则表示拿到了不超过90分的试卷;

- $p(x=1\vert\omega_i)$:表示类别 $i$ 的条件概率,即第$i$类中的某样本特征出现的概率,反映了在 $w_i$类中观察到特征值 $\boldsymbol{x}$ 的可能性(likelihood),也称为似然度,一般是已知的;

- $p(x=1)$:表示两类学生考 90+ 分的概率,是一个全概率;

- $p(\omega_i\vert x=1)$:后验概率,同样也是一个条件概率,表示已知考试成绩为 90+ 分,那么该试卷属于第 $\omega_i$ 类的概率;后验概率也是我们需要求得的概率,通过它可以实现分类,比如选取后验概率最大者对应的类别作为分类结果。

可以看出,后验概率即为我们需要求取的概率。后验概率其实是在衡量各组分对结果的贡献,概率大,表示所有此结果中该组分(类)占比大。在引例中不知道那张试卷分数时,卷子可能属于10个人中的任意一人,即两个组分(类别)在概率上都贡献了5个人,各占0.5。而在知道卷面成绩90+后,贡献就悄然发生了变化。

已知学渣和学霸各占总样本的一半人数也就是5人,则先验概率为

\[p(w_1)=0.5, p(w_2)=0.5\]假设通过以往所有的考试信息,得出w1组得分90+的概率为0.2,w2组得分90+的概率为0.8,即条件概率(似然度)为

\[p(x=1|w_1)=0.2, p(x=1|w_2)=0.8\]代入贝叶斯公式即可求得后验概率

\[\begin{aligned} p(w_1|x=1)&=\frac{0.2*0.5}{0.2*0.5+0.8*0.5}=0.2, \\ p(w_2|x=1)&=\frac{0.8*0.5}{0.2*0.5+0.8*0.5}=0.8 \end{aligned}\]可以看出,成绩90+的试卷属于$w_1$ 组的概率为0.2,属于 $w_2$ 组的概率为0.8,因此这张卷子更有可能是学霸的。

贝叶斯公式特点:

- 条件概率(似然度)是计算后验概率的基础,是通过大量统计来得到的,这就是大数定理。

- 许多事件的发生不具有可重复性,所以条件概率只能根据对置信度的主观判断,然后再以新获得的信息对条件概率进行修正。

- 贝叶斯决策是基于概率的,所以分类决策一定存在错误率,即使错误率很低。

贝叶斯决策就是在贝叶斯公式计算出后验概率的基础上,进一步做归属的决定——分类,如上述引例中,决策就是决定90+或者不超过90分的卷子归于 $w_1$ 组(类)或者归于 $w_2$ 组(类)。

不同的贝叶斯分类器有不同的贝叶斯决策,其主要包括两种决策方式,即最小错误贝叶斯决策,和最小风险贝叶斯决策。

2. 最小错误贝叶斯决策

2.1. 直观举例

最小错误贝叶斯决策就是选择后验概率最大的类作为判断的决策。

上述例中,在 $x=1$ 时,由于

\[p(w_1|x=1)=0.2 < p(w_2|x=1)=0.8\]所以将90+的卷子归属到 $w_2$,犯错的概率会最小。犯错的概率就是90+的卷子可能属于 $w_1$ 的概率,即 \(p(w_1|x=1)=0.2 = 1 - p(w_2|x=1)\)

同理,在 $x=0$ 时,将90或者90-的卷子归属到 $w_1$,犯错的概率会最小。犯错的概率是

\[p(w_2|x=0)=0.2=1 - p(w_1|x=0)\]上述例子是符合直觉的,在数学上需要更为严谨的推导。

2.2. 类概率密度

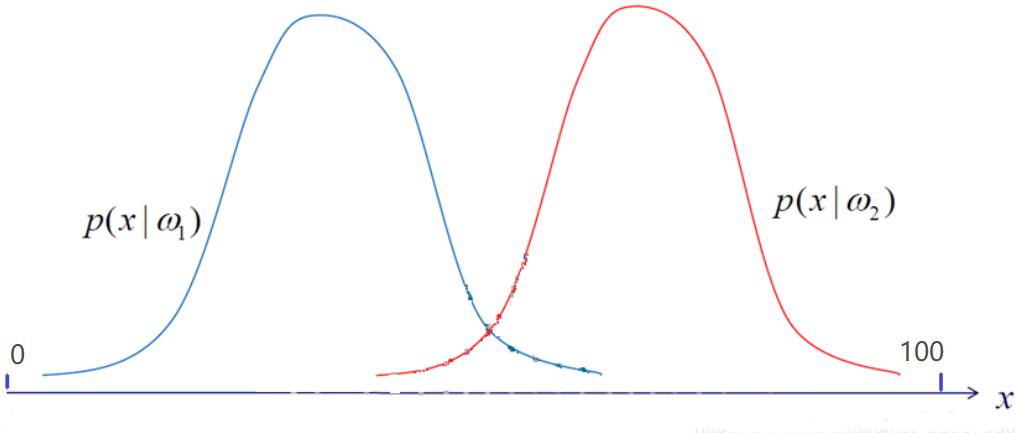

对于前述例子,会觉得它更像是一个简单的数学问题,而不是一个模式识别问题。因为在实际模式识别中,首先,待分类数据 $x$ 往往不会只有 $[0,1]$ (此处为 90+分和不足90分)两种取值,而会是一系列取值,如得分为 $[0,1,\cdots,99,100]$;对应的类的条件概率往往不是几个孤立的冲激,而是一个连续的概率密度函数(PDF),如下图所示:

类条件概率反映出样本在特征空间的分布(学渣的卷面分数分布和学霸的卷面分数分布),这个分布一般而言是需要根据样本数据统计计算得到的。正因为不同类别的类条件概率分布在特征空间会重叠,导致了判决错误的发生。

2.3. 错误率分析

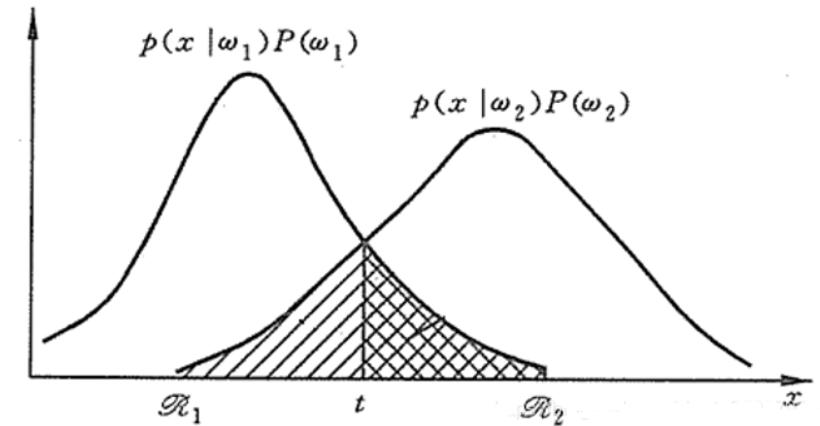

为什么最小错误率贝叶斯决策的错误率是最小的?从定义出发:选择后验概率最大的类作为判断的决策。以一维二分类问题进行说明。对于两类问题,统计判决的基本方法是根据前述类的概率和概率密度将模式的特征空间划分为两个子区域 $\mathcal{R}_1, \mathcal{R}_2$,当 $x\in\mathcal{R}_1$ 时判断为 $x\in w_1$ 类,当 $x\in\mathcal{R}_2$ 时判断为 $x\in w_2$ 类。则错误率取决于两个子空间的划分情况,或者说两个子空间分界面 $t$ 的选择。

显然,此时会发生两种错误:

- 把实际是 $w_1$ 类的样本错误判断为 $w_2$ 类。这种情况发生的原因是属于 $w_1$ 类的特征分布在 $w_2$ 的特征空间区域 $\mathcal{R}_2$ 中。这时,误判概率为(图中方格区域的面积)

- 另一种错误是把实际是 $w_2$ 类的样本错误判断为 $w_1$ 类。这种情况发生的原因是属于 $w_2$ 类的特征分布在 $w_1$ 的特征空间区域 $\mathcal{R}_1$ 中。这时,误判概率为(图中斜纹区域的面积)

考虑到两个类别发生的概率分别为 $p(w_1), p(w_2)$ ,则总的误判概率为

\[p(e) = p(w_1) \cdot p(e_1)+ p(w_2) \cdot p(e_2) = p(w_1)\int_{\mathcal{R}_2} p(x \vert w_1)\text{d}x + p(w_2)\int_{\mathcal{R}_1} p(x \vert w_2)\text{d}x\]其中 $p(w_1), p(w_2)$ 对于积分来说是与 $x$ 无关的常数,因此可以在积分符号内或者外出现。

我们希望总错误率最小,等价于希望总的正确判断的概率最大,总正确率为

\[p(c) = p(w_1)\int_{\mathcal{R}_1} p(x \vert w_1)\text{d}x + p(w_2)\int_{\mathcal{R}_2} p(x \vert w_2)\text{d}x \tag{2}\]注意到($w_2$ 类别在全空间要么判断正确要么判断错误)

\[\begin{aligned} 1 &= \int_{\mathcal{R}_1} p(x \vert w_2)\text{d}x + \int_{\mathcal{R}_2} p(x \vert w_2)\text{d}x \\ \Rightarrow \quad p(w_2) &= p(w_2)\int_{\mathcal{R}_1} p(x \vert w_2)\text{d}x + p(w_2)\int_{\mathcal{R}_2} p(x \vert w_2)\text{d}x\\ \Rightarrow \textcolor{blue}{\quad p(w_2)\int_{\mathcal{R}_2} p(x \vert w_2)\text{d}x} &= p(w_2) - p(w_2)\int_{\mathcal{R}_1} p(x \vert w_2)\text{d}x \\ \end{aligned} \tag{3}\]上述等式左边代入式 $(2)$,有

\[\begin{aligned} p(c) &= p(w_1)\int_{\mathcal{R}_1} p(x \vert w_1)\text{d}x + p(w_2) - p(w_2)\int_{\mathcal{R}_1} p(x \vert w_2)\text{d}x\\ &= p(w_2) + \int_{\mathcal{R}_1} [\;p(w_1)p(x \vert w_1)-p(w_2) p(x \vert w_2)\;]\text{d}x\\ \end{aligned}\]式中 $\mathcal{R}_1$ 是未知的,直接求解很困难。但考查上式可以发现,为了使其最大,$w_1$ 的决策域 $\mathcal{R}_1$ 应该是 $R$ 中所有满足条件

\[p(w_1)p(x \vert w_1) > p(w_2)p(x \vert w_2)\]的样本点组成的集合。

同理(对式$(2)$左右同时乘以$p(w_1)$然后代入式$(1)$ 得到另一个$p(c)$ 的表达式进行分析),决策域 $\mathcal{R}_2$ 应该是 $R$ 中所有满足条件

\[p(w_1)p(x \vert w_1) < p(w_2)p(x \vert w_2)\]的样本组成的集合。

易知,任何其他划分对应的正确率都要小于按照上述划分的正确率。所以,最小错误率贝叶斯决策(选择后验概率最大的类作为判断)的错误率是最小的。即最小错误贝叶斯决策 = 最大后验贝叶斯决策。此时决策面 $t$ 正好为两类的类条件概率密度函数的交点。由于概率非负,如果每一次决策错误率都最小,那么总的错误率也是最小的。

根据前述决策规则,只需要比较类的概率密度函数乘以一个常数(先验概率,不随采样而变,是一个常数值)的结果。显然,图中 $t$ 为决策点,在 $x<t$ 时,对产生数据 $x$ 的贡献 $w_1$ 大于 $w_2$,故最小错误贝叶斯决策将 $x$ 归属为 $w_1$,在 $x>t$ 时,对产生数据 $x$ 的贡献 $w_2$ 大于 $w_1$,故最小错误贝叶斯决策将 $x$ 归属为 $w_2$。

若为 $c$ 分类问题,贝叶斯错误率为

\[p(e) = \int[1- \max_i p(w_i \vert x)]p(x)\text{d}x\]

2.4. 决策规则

根据前述错误率分析,我们需要选择后验概率最大的类作为分类决策规则。对于 $c$ 分类任务,后验概率为

\[p(w_i \vert \boldsymbol{x}) = \frac{p(\boldsymbol{x} \vert w_i)p(w_i)}{ p(\boldsymbol{x})} = \frac{p(\boldsymbol{x} \vert w_i)p(w_i)}{\sum_{j=1}^c p(\boldsymbol{x} \vert w_j)p(w_j)},i=1,2, \cdots c\]与二分类的分类规则类似,有

【决策规则1】

\[p(w_i \vert \boldsymbol{x}) = \max\; p(w_j \vert \boldsymbol{x}), j\in[1,c] \quad \Rightarrow \boldsymbol{x}\in w_i\]后验概率用贝叶斯公式展开后,由于分母的 $p(\boldsymbol{x})$ 相同,因此可以忽略分母直接比较分子,得到等效分类规则如下

【决策规则2】

\[p(\boldsymbol{x} \vert w_i)p(w_i) = \max\; [p(\boldsymbol{x} \vert w_j)p(w_j)], j\in[1,c] \quad \Rightarrow \boldsymbol{x}\in w_i\]由于先验概率 $p(w_i)$ 是事先确定的,与当前样本 $\boldsymbol{x}$ 无关,因此人们经常把二分类问题的决策规则整理成下面的形式

【决策规则3】

\[l(\boldsymbol{x})=\frac{p(\boldsymbol{x}\vert w_1)}{p(\boldsymbol{x}\vert w_2)} \gtrless \frac{p(w_2)}{p(w_1)}=\lambda \quad \Rightarrow \boldsymbol{x} \in \left\{ \begin{matrix} w_1\\ w_2 \end{matrix} \right.\]上式中,概率密度值 $p(\boldsymbol{x}\vert w_i)$ 即为前面贝叶斯公式介绍时提到的似然度,两类似然度的比值 $l(\boldsymbol{x})$ 被称为似然比(likelihood ratio)。这样可以事先计算出阈值 $\lambda$,对每一个样本计算似然比 $l(\boldsymbol{x})$ 并与 $\lambda$ 比较,大于阈值则决策为第一类,反之决策为第二类。

更进一步,许多情况下,用对数形式计算可能更加方便,因此人们定义了负对数似然比

\[h(\boldsymbol{x}) = -\ln[l(\boldsymbol{x})] = -\ln[p(\boldsymbol{x}\vert w_1)] + \ln[p(\boldsymbol{x}\vert w_2)]\]相应的决策规则为

【决策规则4】

\[h(\boldsymbol{x})\lessgtr\ln\frac{p(w_1)}{p(w_2)} \quad \Rightarrow \boldsymbol{x} \in \left\{ \begin{matrix} w_1\\ w_2 \end{matrix} \right.\]负对数似然比 $h(\boldsymbol{x})$ 是 $\boldsymbol{x}$ 的函数,由于 $\boldsymbol{x}$ 是一个随机向量,则 $h(\boldsymbol{x})$ 也是随机变量,其概率分布密度函数可定义为 $p(h\vert w_i)$。由于该函数是一维概率密度函数,易于积分,所以用它计算错误率较为方便,则二分类的错误率可表述为

\[\begin{aligned} p(e_1) &= \int_{\mathcal{R}_2} p(x \vert w_1)\text{d}x = \int_{t}^{+\infty} p(h \vert w_1)\text{d}h\\ p(e_2) &= \int_{\mathcal{R}_1} p(x \vert w_2)\text{d}x = \int_{-\infty}^{t} p(h \vert w_2)\text{d}h \end{aligned}\tag{4}\]其中 $t = \ln\frac{p(w_1)}{p(w_2)}$。

只要 $h(\boldsymbol{x})$ 的概率密度的解析形式已知,就可以计算出错误率。需要注意的是,当 $\boldsymbol{x}$ 是高维特征时,总错误率涉及到多重积分,计算比较困难,因此只能在一些特定简化条件下进行错误率的理论计算。比如在下一章节中,假设样本特征服从正态分布,可以对最小错误贝叶斯决策展开分析,导出分类器的解析表达式和错误率的解析形式。

3. 正态分布样本的最小错误贝叶斯决策

正态分布假设是工程应用中最普遍的假设,因为:

- 正态分布在数学上比较简单,便于进行分析

- 正态分布在物理上经常是总体分布的合理近似

本节着重讨论样本分布属于正态分布时,最小错误率贝叶斯决策的情况。

3.1. 多元正态分布

对于样本特征 $\boldsymbol{x}=[x_1,x_2,\cdots,x_d]^\top$ 的多元正态分布的概率密度函数定义为

\[p(\boldsymbol{x}) = \frac{1}{\sqrt{(2\pi)^d\vert\boldsymbol{\Sigma}\vert} }e^{-\frac{1}{2}(\boldsymbol{x}-\boldsymbol{\mu})^\top\boldsymbol{\Sigma}^{-1}(\boldsymbol{x}-\boldsymbol{\mu})}\]其中均值向量和协方差矩阵分别为

\[\begin{aligned} \boldsymbol{\mu} &= \mathbb{E}[\boldsymbol{x}] = (\mu_1,\mu_2,\cdots,\mu_d)^\top\in\mathbb{R}^{d}\\ \boldsymbol{\Sigma} &= \mathbb{E}[(\boldsymbol{x}-\boldsymbol{\mu})(\boldsymbol{x}-\boldsymbol{\mu})^\top] = [\sigma^2_{ij}]\in\mathbb{R}^{d\times d}\\ \end{aligned}\]正态分布有几个优良性质(后面会用到)

- 正态分布的边缘分布仍然是正态分布

- 正态分布的条件分布仍然是正态分布

- 正态分布各分量的线性组合仍然是正态分布

已知最小错误率贝叶斯决策的判别函数为

\[g_i(\boldsymbol{x}) = p(\boldsymbol{x}\vert w_i)p(w_i),\;i=1,2,\cdots,c\]假设特征的先验概率符合多元正态分布,代入上式取自然对数,得到判别函数为

\[\begin{aligned} \ln g_i(\boldsymbol{x}) &= \ln p(\boldsymbol{x}\vert w_i) + \ln p(w_i)\\ &= \ln \frac{1}{\sqrt{(2\pi)^d\vert\boldsymbol{\Sigma}\vert}} -\frac{1}{2}(\boldsymbol{x}-\boldsymbol{\mu})^\top\boldsymbol{\Sigma}^{-1}(\boldsymbol{x}-\boldsymbol{\mu}) + \ln p(w_i)\\ &= -\frac{d}{2}\ln(2\pi) - \frac{1}{2}\ln\vert\boldsymbol{\Sigma}\vert - \frac{1}{2}(\boldsymbol{x}-\boldsymbol{\mu})^\top\boldsymbol{\Sigma}^{-1}(\boldsymbol{x}-\boldsymbol{\mu}) + \ln p(w_i)\\ \end{aligned}\]对于贝叶斯决策,决策面方程为

\[g_i(\boldsymbol{x}) = g_j(\boldsymbol{x})\]即

\[-\frac{1}{2}[(\boldsymbol{x}-\boldsymbol{\mu})^\top\boldsymbol{\Sigma}^{-1}(\boldsymbol{x}-\boldsymbol{\mu}) - (\boldsymbol{x}_j-\boldsymbol{\mu})^\top\boldsymbol{\Sigma}^{-1}(\boldsymbol{x}_j-\boldsymbol{\mu})]-\frac{1}{2}\ln\frac{\vert\boldsymbol{\Sigma_i}\vert}{\vert \boldsymbol{\Sigma_j}\vert} + \ln \frac{p(w_i)}{p(w_j)} = 0\]3.2. 各类协方差矩阵相等且为特殊对角阵

假设样本的特征向量的各个分量独立且具有相同的方差 $\sigma^2$,即 $\boldsymbol{\Sigma}_1 = \boldsymbol{\Sigma}_2 = \boldsymbol{\Sigma} = \sigma^2\boldsymbol{I}$,此时有

\[\boldsymbol{\Sigma}_i = \sigma^2\boldsymbol{I},\quad\vert\boldsymbol{\Sigma}_i\vert = \sigma^{2d},\quad\boldsymbol{\Sigma}_i^{-1} = \frac{1}{\sigma^2}\boldsymbol{I},\quad i=1,2,\cdots,c\\\]判别函数简化为

\[g_i(\boldsymbol{x}) = -\frac{1}{2\sigma^2}(\boldsymbol{x}-\boldsymbol{\mu})^\top(\boldsymbol{x}-\boldsymbol{\mu})- \frac{d}{2}\ln {2\pi} - \frac{1}{2}p(w_i)\]假设 $c$ 个类别的先验概率均相同( $p(w_i)=p(w_j),\forall i,j=1,2,\cdots,c$),并且注意到贝叶斯决策要求对不同类别的判别函数进行比较,那么可以忽略所有与类别无关的常数。则判别函数进一步简化为

\[\begin{aligned} g_i(\boldsymbol{x}) &= -\frac{1}{2\sigma^2}(\boldsymbol{x}-\boldsymbol{\mu})^\top(\boldsymbol{x}-\boldsymbol{\mu}) = -\frac{1}{2\sigma^2}\Vert \boldsymbol{x}-\boldsymbol{\mu} \Vert^2 \end{aligned}\]可以看出,若要对位置样本进行分类,只需要计算该样本特征特征向量到各类均值的欧式距离,然后把样本归类到距离最近的类别即可,说明此时的最小错误率贝叶斯分类器等价于最小距离分类器或垂直平分分类器。

继续对判别函数进行线性化,有

\[\begin{aligned} g_i(\boldsymbol{x}) &=-\frac{1}{2\sigma^2}(\boldsymbol{x}-\boldsymbol{\mu})^\top(\boldsymbol{x}-\boldsymbol{\mu}) \quad \textcolor{blue}{\text{Euclidean Distance}}\\ &= -\frac{1}{2\sigma^2}(-2\boldsymbol{\mu}_i^\top \boldsymbol{x}+\boldsymbol{\mu}_i^\top \boldsymbol{\mu}_i)\\ &= \frac{1}{\sigma^2}\boldsymbol{\mu}_i^\top\boldsymbol{x} - \frac{1}{2\sigma^2}\boldsymbol{\mu}^\top \boldsymbol{\mu}\\ &= \boldsymbol{w}_i^\top\boldsymbol{x} + w_{i0}\quad \textcolor{blue}{\text{linear}} \end{aligned}\]可以看出决策面确实是一个超平面。如果先验概率 $p(w_i)\neq p(w_j)$,则决策面向先验概率小的那一类平移。

3.3. 各类协方差矩阵相等

假设各类协方差矩阵相等(即$\boldsymbol{\Sigma}_1 = \boldsymbol{\Sigma}_2 = \boldsymbol{\Sigma}$,但不再满足 $\boldsymbol{\Sigma} = \sigma^2\boldsymbol{I}$),再假设各类先验概率相等,判别函数简化为

\[\begin{aligned} g_i(\boldsymbol{x}) &= -\frac{1}{2}(\boldsymbol{x}-\boldsymbol{\mu}_i)^\top\boldsymbol{\Sigma}^{-1}(\boldsymbol{x}-\boldsymbol{\mu}_i)\quad \textcolor{blue}{\text{Mahalanobis Distance}}\\ &= -\frac{1}{2}(\textcolor{red}{\boldsymbol{x}^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{x}}-2\boldsymbol{\mu}_i^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{x} + \boldsymbol{\mu}_i^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_i)\\ &= -\boldsymbol{\mu}_i^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{x} + \frac{1}{2}\boldsymbol{\mu}^\top\boldsymbol{\Sigma}^{-1} \boldsymbol{\mu}\quad \textcolor{blue}{\text{ignore constant}}\\ &=\boldsymbol{w}_i^\top\boldsymbol{x} + w_{i0}\quad \textcolor{blue}{\text{linear}}\\ \end{aligned}\]注意因为协方差矩阵相等,因此对于不同类别来说展开后第一项(标红)都是常数,因此可以忽略。

此时决策规则为按最小马氏距离的平方进行判别。按马氏距离判别仍然是线性的。

马氏距离:$D_M(\boldsymbol{x},\boldsymbol{\mu}) = \sqrt{(\boldsymbol{x}-\boldsymbol{\mu})^\top \boldsymbol{\Sigma}^{-1}(\boldsymbol{x}-\boldsymbol{\mu})} $

类似地,如果先验概率相等,则决策面过均值向量连线的终点(但不再垂直)。如果先验概率 $p(w_i)\neq p(w_j)$,则决策面向先验概率小的那一类平移。

继续分析该情况下的错误率,将复对数似然比展开得到

\[\begin{aligned} h(\boldsymbol{x}) &= -\ln[p(\boldsymbol{x}\vert w_1)] + \ln[p(\boldsymbol{x}\vert w_2)] \\ &=\frac{1}{2}[(\boldsymbol{x}-\boldsymbol{\mu}_1)^\top\boldsymbol{\Sigma}_1^{-1}(\boldsymbol{x}-\boldsymbol{\mu}_1) - (\boldsymbol{x}-\boldsymbol{\mu}_2)^\top\boldsymbol{\Sigma}_2^{-1}(\boldsymbol{x}-\boldsymbol{\mu}_2)] + \frac{1}{2}\ln\frac{\vert\boldsymbol{\Sigma}_1\vert}{\vert \boldsymbol{\Sigma}_2\vert}\\ &= (\boldsymbol{\mu}_2 - \boldsymbol{\mu}_1)^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{x} + \frac{1}{2}(\boldsymbol{\mu}_1^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_1-\boldsymbol{\mu}_2^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_2)\\ &= \boldsymbol{a}^\top\boldsymbol{x} + \boldsymbol{b}\quad \textcolor{blue}{\text{linear}} \end{aligned}\]可以看出,负对数似然比是关于 $\boldsymbol{x}$ 的线性函数,又已知 $\boldsymbol{x}$ 服从正态分布,则负对数似然比也是一维正态分布。对于负对数似然比的两个类条件概率密度函数 $p(h\vert w_1),p(h\vert w_2)$ 也服从正态分布,分别计算其一维正态分布的均值和方差。

均值为

\[\begin{aligned} \eta_1 &= \mathbb{E}[h(\boldsymbol{x})\vert w_1] = h(\boldsymbol{\mu}_1)\\ &= (\boldsymbol{\mu}_2 - \boldsymbol{\mu}_1)^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_1 + \frac{1}{2}(\boldsymbol{\mu}_1^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_1-\boldsymbol{\mu}_2^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_2)\\ &= \textcolor{red}{\boldsymbol{\mu}_2^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_1} - \frac{1}{2}\boldsymbol{\mu}_1^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_1 -\frac{1}{2}\boldsymbol{\mu}_2^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_2\\ &= - \frac{1}{2}\boldsymbol{\mu}_1^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_1 + \textcolor{red}{\frac{1}{2}\boldsymbol{\mu}_1^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_2+\frac{1}{2}\boldsymbol{\mu}_2^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_1} - \frac{1}{2}\boldsymbol{\mu}_2^\top\boldsymbol{\Sigma}^{-1}\boldsymbol{\mu}_2\quad (\Sigma\;\text{is symmetric})\\ &= -\frac{1}{2}(\boldsymbol{\mu}_2 - \boldsymbol{\mu}_1)^\top\boldsymbol{\Sigma}^{-1}(\boldsymbol{\mu}_2 - \boldsymbol{\mu}_1)\\ &= -\frac{1}{2}D_M(\boldsymbol{\mu_2},\boldsymbol{\mu_1})^2 = -\eta \end{aligned}\]考虑对多元正态分布的线性变换,其方差定义为:

\[\begin{aligned} Var(h(\boldsymbol{x})\vert w_1) &= \boldsymbol{a}^\top\boldsymbol{\Sigma}\boldsymbol{a}\\ &= (\boldsymbol{\mu}_2 - \boldsymbol{\mu}_1)^\top \boldsymbol{\Sigma}^{-1}\boldsymbol{\Sigma}\boldsymbol{\Sigma}^{-1}(\boldsymbol{\mu}_2 - \boldsymbol{\mu}_1)\\ &= (\boldsymbol{\mu}_2 - \boldsymbol{\mu}_1)^\top\boldsymbol{\Sigma}^{-1}(\boldsymbol{\mu}_2 - \boldsymbol{\mu}_1)\\ &= D_M(\boldsymbol{\mu_2},\boldsymbol{\mu_1})^2 = 2\eta \end{aligned}\]所以

\[p(h(\boldsymbol{x})\vert w_1)\sim N(-\eta, 2\eta)\]同理可得

\[\begin{aligned} p(h(\boldsymbol{x})\vert w_2)\sim N(\eta, 2\eta) \end{aligned}\]至此,我们就得到了负对数似然比(服从一维正态分布)在两个类条件概率密度函数 $p(h\vert w_1),p(h\vert w_2)$ 的均值和方差。代入式 $(4)$ 可以计算两种情况下的错误率

\[\begin{aligned} p(e_1) &= \int_t^{+\infty} p(h\vert w_1)dh \\ &= \int_t^{+\infty} \frac{1}{(2\pi)^{0.5}\sigma} \text{exp}\left\{\frac{1}{2}(\frac{h+\eta}{\sigma})^2\right\} dh\\ &= \int_t^{+\infty} \frac{1}{(2\pi)^{0.5}} \text{exp}\left\{\frac{1}{2}(\frac{h+\eta}{\sigma})^2\right\} d(\frac{h+\eta}{\sigma})\\ &= \int_{\frac{t+\eta}{\sigma}}^{+\infty} \frac{1}{(2\pi)^{0.5}} \text{exp}\left\{\frac{1}{2}\varepsilon^2\right\} d\varepsilon \sim N(0,1) \end{aligned}\] \[\begin{aligned} p(e_2) &= \int_{-\infty}^t p(h\vert w_2)dh \\ &= \int_{-\infty}^t \frac{1}{(2\pi)^{0.5}\sigma} \text{exp}\left\{\frac{1}{2}(\frac{h-\eta}{\sigma})^2\right\} dh\\ &= \int_{-\infty}^t \frac{1}{(2\pi)^{0.5}} \text{exp}\left\{\frac{1}{2}(\frac{h-\eta}{\sigma})^2\right\} d(\frac{h+\eta}{\sigma})\\ &= \int_{-\infty}^{\frac{t-\eta}{\sigma}} \frac{1}{(2\pi)^{0.5}} \text{exp}\left\{\frac{1}{2}\varepsilon^2\right\} d\varepsilon \sim N(0,1) \end{aligned}\]已知 $t,\boldsymbol{\mu}_1, \boldsymbol{\mu}_2, \boldsymbol{\Sigma}_1, \boldsymbol{\Sigma}_2$ 时,查标准正态分布表就能得到两个错误率。

实际上,贝叶斯错误率可以写为标准正态分布的累积分布函数的形式:

\[p(e) = \Phi(-\frac{1}{2}D_M(\boldsymbol{\mu_2},\boldsymbol{\mu_1}))\]标准正态分布的累积分布函数(CDF)表示标准正态分布(均值为 0,方差为 1)在 $z$ 左侧的概率

\[\Phi(z) = \frac{1}{\sqrt{2\pi}}\int_{-\infty}^{z}e^{-\frac{x^2}{2}}dx\]由于标准正态分布是对称的,$\Phi(z) = 1-\Phi(-z)$,因此

\[p(e) = 1-\Phi(\frac{1}{2}D_M(\boldsymbol{\mu_2},\boldsymbol{\mu_1}))\]可分析如下:

- 当马氏距离为 0 时,CDF 值为 0.5,此时错误率是 0.5(原始样本特征的概率密度函数重合,相当于随机猜测)

- 当马氏距离增大时,CDF 值不断减小,此时错误率单调递减;

- 当马氏距离为正无穷时,此时错误率趋近于 0(原始样本特征的概率密度函数几乎完全分离)

但是还是要注意,以上分析的前提是类条件概率密度可以被精确估计。实际上,样本量有限,无法准确估计概率密度。另外,特征增加当然可能使错误率反而增加,除了因为估计不准确之外,还可能是高斯密度这个前提本身就是不准的。而且,样本量小而特征很多,无疑会带来很多麻烦,比如过拟合等。

3.4. 各类协方差不等(一般情况)

判别函数(忽略常数项后)形式如下:

\[\begin{aligned} g_i(\boldsymbol{x}) &= - \frac{1}{2}(\boldsymbol{x}-\boldsymbol{\mu})^\top\boldsymbol{\Sigma}_i^{-1}(\boldsymbol{x}-\boldsymbol{\mu}) - \frac{1}{2}\ln\vert\boldsymbol{\Sigma}_i\vert + \ln p(w_i)\\ &= -\frac{1}{2}\boldsymbol{\Sigma}_i^{-1}\boldsymbol{x} + \boldsymbol{\Sigma}_i^{-1}\boldsymbol{\mu}_i\boldsymbol{x} -\frac{1}{2}\boldsymbol{\mu}_i^\top\boldsymbol{\Sigma}_i^{-1}\boldsymbol{\mu}_i -\frac{1}{2}\ln\vert\boldsymbol{\Sigma}_i\vert + \ln p(w_i)\\ &=\boldsymbol{x}^\top\boldsymbol{W}^{-1}\boldsymbol{x} + \boldsymbol{w}_i^\top\boldsymbol{x} + w_{i0}\\ \end{aligned}\]这类判别函数为 $\boldsymbol{x}$ 的二次型,决策面为二次超曲面,当 $\boldsymbol{\Sigma}_i,\boldsymbol{\mu},p(w_i)$的的取值不同时,形成的曲面形状也不一样,有超球面、超椭球面、超抛物面、超双曲面等。

4. 最小风险贝叶斯决策

最小错误率决策足以胜任一般的决策场景。但是如果考虑不同的决策错误会带来不同的风险,则需要赋予不同的权重。比如,如果一个人处于癌症早期,而模型判定他是正常的,那此类决策可能带来生命的代价,因此需要给此类决策高权重。而如果一个人是正常的,模型判定他为癌症早期,代价是给病人和家属带来巨大的精神负担,但相对于生命而言可能相对可以接受,因此需要给此类决策低权重。显然,判定正确没有代价,权重为0。

4.1. 举例说明

还是用上述引例深入分析,假设把一张学渣的($w_1$)卷子错判成学霸的($w_2$),会对学渣造成 10点 暴击伤害(因为导致学渣以为自己进步神速最后还是会被无情打碎幻想),反之如果把一张学霸的卷子判成学渣只有 1点 普通伤害(学霸很自信不会轻易动摇)。如果判定正确,大家则相安无事。那么我们就为学渣($w_1$)的卷子判定成学霸($w_2$)的决策加 10 点权值,然后为学霸($w_2$)的卷子判定成学渣($w_1$)的决策加 1 点权值,判断正确的权值为零,那我们可以得到如下决策表。

| 决策 | 真实类别(学渣) | 真实类别(学霸) | |

|---|---|---|---|

| \ | $w_1$ | $w_2$ | |

| 分类结果(学渣) | $w_1$ | 0 | 1 |

| 分类结果(学霸) | $w_2$ | 10 | 0 |

假设同样是抽到了一张90+的卷子,即 $x=1$。对于最小错误贝叶斯决策,$p(\omega_1\vert x=1) = 0.2$,$p(\omega_2\vert x=1) = 0.8$,将该卷子判定为学霸的($w_2$)是最佳决策。

现在如果依旧判定为 $w_2$,那么其风险为 $R = 10 \times 0.2 + 0 \times 0.8 = 2$,而判定为 $w_1$,风险则为 $R_1 = 0* 0.2 + 0.8*1 = 0.8$。对于最小风险贝叶斯决策,判定为 $w_1$ 是最佳决策。剧情出现了 180 度大转弯,说明考虑风险后发现将学渣的卷子误判的代价更高,因此更倾向于误判学霸的卷子。

4.2. 风险因子(损失函数)

从决策论的角度,可将最小风险贝叶斯决策重新表述如下:

- 样本 $\boldsymbol{x}$ 看作 d 维随机向量 $\boldsymbol{x} = [x_1,x_2,\cdots,x_d]^\top$

- 状态空间 $\Omega$ 由 $c$ 个可能的状态组成($c$ 类):$\Omega={w_1,w_2,\cdots, w_c}$

-

对随机向量 $\boldsymbol{x}$ 可能采取的(分类)决策组成了决策空间,它由 $k$ 个决策组成:$A={a_1,a_2,\cdots, a_k}$

注意,这里并没有假定 $k=c$,因为可能采取的(分类)决策除了判别为某一类外,还可能做出拒绝分类的决策,即不能判别样本属于任何一类,有时也可以在决策时把几类合并为同一个大类,等等。

定义对于实际状态为 $w_j$ 的向量 $\boldsymbol{x}$ 采取决策 $a_i$ 所带来的风险因子(损失函数)为

\[\lambda(a_i, w_j)=\lambda_{ij},\quad i= 1,\cdots, k,\; j=1,\cdots, c\]通常可以用表格的形式给出风险因子,被称为决策表。决策表是人在实际应用中根据问题的背景和知识事先给定的。在实际应用中,需要认真分析研究问题的内在特点和分类目的,与应用领域的专家共同设计出适当的决策表,才能保证模式识别发挥有效的作用。

需要注意的是,通常正确分类决策的损失函数 $\lambda(a_i, w_i)=0$,即分类正确的情况下是没有损失的。

4.3. 条件期望风险(条件平均损失)

条件期望风险是指在给定观测数据 $\boldsymbol{x}$ 的条件下,采取某个决策 $a_i$(将其划分为类别 $i$)所产生的期望风险,又称为条件平均损失。

对于样本 $\boldsymbol{x}$ 的各状态后验概率为 $p(w_j \vert \boldsymbol{x}),\;j=1,\cdots,c$,对它采取决策 $a_i,\;i=1,\cdots,k$ 的条件期望风险是

\[R(a_i|\boldsymbol{x})=E[\lambda(a_i,w_j)|\boldsymbol{x}] = \sum_{j=1}^c \lambda(a_i,w_j)p(w_j|\boldsymbol{x}) \tag{5}\]对于特定的决策,其风险是所有后验的概率与风险因子的乘积之和,即不再仅仅考虑后验概率了,还要额外考虑风险因子。

4.4. 判决准则

最小风险贝叶斯决策就是对所有决策 $a_i$ 都分别求出条件期望风险,然后选择条件期望风险最小的决策。具体步骤如下:

- 首先,将先验概率和似然度(经过统计或经验得到)代入贝叶斯公式计算出后验概率(式 $(1)$)。

- 然后,利用后验概率和事先定义的决策表(表格的形式的风险因子),计算条件期望损失(式 $(5)$)。

- 最后,选取其中条件期望损失最小的决策,得到最小风险贝叶斯决策:

显然,对于二分类任务,当 $\lambda(1,1)=\lambda(2,2)=0,\lambda(1,2)=\lambda(2,1)=1$ 时,最小风险贝叶斯决策退化为最小错误贝叶斯决策。

5. 最小最大贝叶斯决策

在最小风险贝叶斯决策中,先验概率 $p(w_i)$ 被认为是确定的。然而在实际应用中,各类的先验概率有时不能精确确定(如从黑箱中拿彩色小球,采样次数不够可能导致对小球颜色估计的先验概率有偏差),或在分析过程中各类的先验概率是变动的。此时,若再用固定先验概率条件下的某个最小风险贝叶斯分类器来进行决策,其结果实际上不是最小风险的。随着先验概率的变化,这个按照之前经验确定的某个具体先验概率取值后得到的最小风险贝叶斯决策,其实际风险可能会变大。

最小最大决策就是在各类的先验概率变化的情况下,取最大风险为最小的某个最小风险贝叶斯分类器作为实际使用的分类器。

5.1. 期望风险

设特征空间 $R$ 中判决域为 $\mathcal{R}_i(i=1,2,\cdots,c)$,于是求得条件期望风险关于 $\boldsymbol{x}$ 的数学期望为

\[R = \sum_{i=1}^c\int_{\mathcal{R}_i} R(\alpha_i \vert \boldsymbol{x})p(\boldsymbol{x}) \text{d}x\]期望风险 $R$ 反映在整个特征空间不同的 $x$ 取值 采取决策 $\alpha(x)$ (决策可看成是随机向量 $x$ 的函数)所带来的平均风险。与之相比,条件期望风险只反映对某 $x$ 取值的决策行动 $\alpha_i$ 所带来的风险。

5.2. 期望风险与先验概率的关系

对于二分类问题,设某个最小风险贝叶斯分类器将特征空间 $R$ 划分为两个子区域,记 $\lambda_{ij}$ 为将实属 $w_j$ 类的样本判为 $w_i$ 的风险因子,则误判的期望风险为

\[\begin{aligned} R &= \int_R R(\alpha \vert \boldsymbol{x})p(\boldsymbol{x}) \text{d}x\\ &= \int_{\mathcal{R}_1} R(\alpha_1 \vert \boldsymbol{x})p(\boldsymbol{x}) \text{d}x + \int_{\mathcal{R}_2} R(\alpha_2 \vert \boldsymbol{x})p(\boldsymbol{x}) \text{d}x\\ &= \int_{\mathcal{R}_1} \sum_{j=1}^2\lambda_{1j} p(\boldsymbol{x}\vert w_j)p(w_j) \text{d}x + \int_{\mathcal{R}_2} \sum_{j=1}^2\lambda_{2j} p(\boldsymbol{x}\vert w_j)p(w_j) \text{d}\quad\textcolor{blue}{\text{using Bayes and definition of}\; R(\alpha\vert x)}\\ &= \lambda_{11}p(w_1)\int_{\mathcal{R}_1} p(\boldsymbol{x}\vert w_1)\text{d}x + \lambda_{12}p(w_2)\int_{\mathcal{R}_1} p(\boldsymbol{x}\vert w_2)\text{d}x + \lambda_{21}p(w_1)\int_{\mathcal{R}_2} p(\boldsymbol{x}\vert w_1)\text{d}x + \lambda_{22}p(w_2)\int_{\mathcal{R}_2} p(\boldsymbol{x}\vert w_2)\text{d}x\\ \end{aligned}\]引入类别 $w_j$ 下样本落在 $\mathcal{R}_i$ 的概率

\[p(\mathcal{R}_i\vert w_j) = \int_{\mathcal{R}_i} p(\boldsymbol{x}\vert w_j)\text{d}x\]将期望风险表示为

\[R = \lambda_{11}p(w_1)p(\mathcal{R}_1\vert w_1) + \lambda_{12}p(w_2)p(\mathcal{R}_1\vert w_2) + \lambda_{21}p(w_1)p(\mathcal{R}_2\vert w_1) + \lambda_{22}p(w_2)p(\mathcal{R}_2\vert w_2)\tag{6}\]又已知(样本要么属于 $w_1$ 类要么属于 $w_2$ 类,要么落在 $\mathcal{R}_1$ 区域要么落在 $\mathcal{R}_2$ 区域)

\[\begin{aligned} p(w_1) + p(w_2) &= 1\\ p(\mathcal{R}_1\vert w_j) + p(\mathcal{R}_2\vert w_j) &= 1\\ \end{aligned}\]代入式 $(6)$ 有

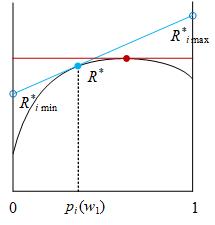

\[\begin{aligned} R &= \lambda_{11}p(w_1)\left[\textcolor{blue}{1 - p(\mathcal{R}_2\vert w_1)}\right] + \lambda_{12}[\textcolor{blue}{1-p(w_1)}]p(\mathcal{R}_1\vert w_2) + \lambda_{21}p(w_1)p(\mathcal{R}_2\vert w_1) + \lambda_{22}[\textcolor{blue}{1-p(w_1)}]\left[\textcolor{blue}{1-p(\mathcal{R}_1\vert w_2)}\right]\\ &= \textcolor{green}{\lambda_{22} + (\lambda_{12}-\lambda_{22})p(\mathcal{R}_1\vert w_2)} + \textcolor{red}{p(w_1)}\textcolor{blue}{[ \lambda_{11}-\lambda_{22} + (\lambda_{21}-\lambda_{11})p(\mathcal{R}_2\vert w_1)+ (\lambda_{22} -\lambda_{12})p(\mathcal{R}_1\vert w_2) ]}\\ &= \textcolor{green}{A} + \textcolor{red}{p(w_1)}\textcolor{blue}{B} \end{aligned} \tag{7}\]在已知类概率密度函数 $p(x\vert w_j)$ 的前提下,一旦 $\mathcal{R}_1,\mathcal{R}_2$ 确定,误判的期望风险是先验概率 $p(w_1)$ 的线性函数,此时不难计算出期望风险的上下界(一定在直线与边界的两个交点分别取得)。

5.3. 最小化最大期望风险

根据我们前述目标,需要最小化前面确定的期望风险的最大值,下面结合图例进行分析

- 外层循环

-

考虑到先验概率不确定性,遍历其取值区间 $[0,1]$,对于第 $i$ 个具体的取值,可以按照最小风险贝叶斯决策的原理设计出最佳的决策域 $\mathcal{R}_1,\mathcal{R}_2$,同时计算出此时的期望风险为 $R^{\star}$

- 内层计算:

- 对 $p(w_1)$ 的第 $i$ 个具体的取值和对应的 $\mathcal{R}_1,\mathcal{R}_2$,考虑 $p(w_1)$ 偏离这个具体取值时的情况。极端情况下,先验概率可能在 $[0,1]$ 区间随意偏离。

- 前面式 $(8)$ 已知期望风险和先验概率 $p(w_1)$ 呈线性关系,那么根据其取值区间 $[0,1]$,代入式 $(8)$ 容易找到其上界(某个端点),记为 $R^{\star}_{i\max}$

- 比较 $R^{\star}_{i\max}$ 和 $R^{\star}$ 的关系

- 如果 $R^{\star}_{i\max}>R^{\star}$ 则表示没有找到最大误判平均风险的极小值(图中蓝线),continue。

- 若满足,则找到最大误判平均风险的极小值(图中红线),break。

- $i = i+1$ 确定下一个先验概率的具体取值,回到第一步。

可以发现,最大的误判期望风险,其极小值情况是最小风险贝叶斯决策域 $\mathcal{R}_1,\mathcal{R}_2$ 使得式 $(8)$ 中的系数 $B=0$,此时无论先验概率 $p(w_1)$ 如何变化,期望风险 $R$ 与先验概率无关(因为系数 $B=0$),从而使的期望风险 $R$ 恒等于常数,最大的期望风险值是所有最小风险贝叶斯决策中最小的,对应的最小风险贝叶斯决策称为最小最大贝叶斯决策。